Data Engineering meistern: Die Grundlage für den Erfolg mit Daten schaffen

Veröffentlicht am

Was ist Data Engineering ?

Quelle : www.educative.io

Unter Datentechnik versteht man das Entwerfen, Entwickeln und Verwalten der Infrastruktur, der Tools und der Prozesse zum Erfassen, Speichern, Verarbeiten und Umwandeln von Daten in ein Format, das für Analysen, Berichte und Entscheidungsfindung genutzt werden kann. Dazu gehören Aufgaben wie Dateneingabe, Datenintegration, Datentransformation, Datenspeicherung und Datenverwaltung, um eine effiziente und effektive Datenverarbeitung zu ermöglichen.

Im heutigen digitalen Zeitalter spielt Data Engineering eine entscheidende Rolle, wenn es darum geht, die Leistungsfähigkeit von Daten zu nutzen, um Erkenntnisse zu gewinnen, fundierte Entscheidungen zu treffen und Geschäftsergebnisse zu erzielen. Hier sind einige Gründe, warum Data Engineering so wichtig ist:

Datengesteuerte Entscheidungsfindung: Data Engineering bildet die Grundlage für die Erfassung, Speicherung und Verarbeitung großer Datenmengen, die analysiert werden können, um wertvolle Erkenntnisse für datengesteuerte Entscheidungen zu gewinnen. Dies hilft Unternehmen, wettbewerbsfähig zu bleiben, Chancen zu erkennen und Herausforderungen in einem sich schnell verändernden Geschäftsumfeld zu bewältigen.

Skalierbarkeit und Effizienz: Data Engineering ermöglicht es Unternehmen, Daten in großem Umfang zu verarbeiten und zu verwalten und große Datenmengen effizient und effektiv zu verarbeiten. Dies ist in der heutigen datengesteuerten Welt, in der Daten exponentiell wachsen und Unternehmen Daten aus verschiedenen Quellen wie sozialen Medien, IoT-Geräten und anderen digitalen Kanälen verarbeiten und analysieren müssen, unerlässlich.

Datenintegration und -konsolidierung: Data Engineering ermöglicht Unternehmen die Integration und Konsolidierung von Daten aus verschiedenen Quellen, wie Datenbanken, Data Warehouses, APIs und externen Datenquellen. Auf diese Weise wird eine einheitliche Sicht auf die Daten geschaffen, die die Konsistenz, Integrität und Genauigkeit der Daten gewährleistet, was für eine zuverlässige Datenanalyse und -berichterstattung entscheidend ist.

Datenqualität und -verwaltung: Data Engineering umfasst Prozesse zur Datenvalidierung, Datenbereinigung und Datenanreicherung, um die Datenqualität und -integrität sicherzustellen. Auf diese Weise können Unternehmen sicherstellen, dass die für die Analyse und Entscheidungsfindung verwendeten Daten korrekt, zuverlässig und vertrauenswürdig sind. Data-Governance-Praktiken wie Datenabstammung, Datenkatalogisierung und Datensicherheit sind ebenfalls von entscheidender Bedeutung für das Data Engineering, um die Einhaltung von Datenvorschriften zu gewährleisten und sensible Daten zu schützen.

Erweiterte Analysen und maschinelles Lernen: Data Engineering legt die Grundlage für fortschrittliche Analysen und maschinelles Lernen, indem es die erforderliche Dateninfrastruktur und Verarbeitungsfunktionen bereitstellt. Dadurch können Unternehmen Erkenntnisse aus komplexen Datensätzen ableiten, Vorhersagemodelle erstellen und Algorithmen für maschinelles Lernen für verschiedene Anwendungsfälle implementieren, z. B. personalisierte Empfehlungen, Betrugserkennung und Kundensegmentierung.

Insgesamt spielt Data Engineering eine entscheidende Rolle, wenn es darum geht, Daten effektiv zu verwalten und zu verarbeiten, ihren Wert zu erschließen und in der heutigen datengesteuerten Welt Wettbewerbsvorteile zu erzielen.

Was ist der Data-Engineering-Stack?

Ein typischer Data-Engineering-Stack besteht aus mehreren Schlüsselkomponenten, die je nach den spezifischen Anforderungen und den von einem Unternehmen verwendeten Technologien variieren können. Zu den üblichen Komponenten eines Data-Engineering-Stacks gehören jedoch unter anderem:

Datenquellen: Dies sind die verschiedenen Datenquellen, aus denen die Daten in die Data-Engineering-Pipeline eingespeist werden. Dazu können strukturierte Daten aus relationalen Datenbanken, unstrukturierte Daten aus Quellen wie sozialen Medien, halbstrukturierte Daten aus APIs und mehr gehören.

Dateneingabe-Tools: Dies sind die Tools oder Technologien, die zum Sammeln und Einlesen von Daten aus verschiedenen Quellen in die Data Engineering Pipeline verwendet werden. Dazu können Tools wie Apache Kafka, Apache Nifi, AWS Kinesis oder benutzerdefinierte Skripte für die Datenaufnahme gehören.

Datenspeicherung: Diese Komponente umfasst die Speicherung der aufgenommenen Daten in einer geeigneten Datenspeicherlösung. Dies kann traditionelle relationale Datenbanken wie MySQL, PostgreSQL, NoSQL-Datenbanken wie MongoDB, Cassandra oder Big-Data-Speicherlösungen wie Hadoop Distributed File System (HDFS), Apache Spark oder Cloud-basierte Datenspeicherdienste wie Amazon S3, Google Cloud Storage oder Microsoft Azure Blob Storage umfassen.

Datenverarbeitung und -umwandlung: Diese Komponente umfasst die Verarbeitung und Umwandlung der Daten in ein Format, das für Analysen, Berichte und andere nachgelagerte Anwendungsfälle geeignet ist. Dies kann Datenvalidierung, Datenbereinigung, Datenanreicherung, Datenaggregation, Datenintegration und andere Datentransformationsaufgaben umfassen. Beliebte Tools für die Datenverarbeitung und -umwandlung sind Apache Spark, Apache Flink, Apache Beam und Apache Airflow.

Datenintegration: Diese Komponente umfasst die Integration von Daten aus verschiedenen Quellen, um eine einheitliche Sicht auf die Daten zu schaffen. Dies kann Datenintegrationstools wie Apache Nifi, Talend oder benutzerdefinierte ETL-Skripte (Extrahieren, Transformieren, Laden) umfassen, um Daten aus verschiedenen Quellen zu verschieben und zu integrieren.

Datenmodellierung und Datenbankdesign: Diese Komponente umfasst den Entwurf und die Implementierung des Datenmodells und des Datenbankschemas zur effizienten Speicherung und Verwaltung von Daten. Dies kann relationale Datenbankmanagementsysteme (RDBMS) wie MySQL, PostgreSQL oder Cloud-basierte verwaltete Datenbanken wie Amazon RDS, Google Cloud SQL oder Microsoft Azure SQL Database umfassen.

Datenverwaltung und -sicherheit: Diese Komponente umfasst die Implementierung von Data-Governance-Verfahren und die Gewährleistung der Datensicherheit. Dies kann Datenabfolge, Datenkatalogisierung, Datenzugriffskontrollen, Verschlüsselung und andere Sicherheitsmaßnahmen umfassen, um sensible Daten zu schützen und die Einhaltung von Datenvorschriften zu gewährleisten.

Datenüberwachung und -qualitätssicherung: Diese Komponente umfasst die Überwachung von Datenpipelines, die Validierung der Datenqualität und die Gewährleistung der Datengenauigkeit und -integrität. Dies kann Tools wie Apache Atlas, Apache NiFi Registry oder benutzerdefinierte Überwachungs- und Qualitätssicherungsskripte umfassen.

Datenvisualisierung und Berichterstattung: Diese Komponente umfasst die Visualisierung und Berichterstellung von Daten für Geschäftsinteressenten. Dazu können Tools wie Tableau, Power BI oder

Was sind die besten Praktiken für die Entwicklung und Implementierung skalierbarer Datenpipelines?

Quelle : symphony-solutions.com

Die Entwicklung und Implementierung skalierbarer Datenpipelines erfordert eine sorgfältige Planung und die Einhaltung bewährter Verfahren, um eine effiziente und zuverlässige Datenverarbeitung zu gewährleisten. Im Folgenden finden Sie einige wichtige Best Practices, die Sie berücksichtigen sollten:

Definieren Sie klare Ziele: Definieren Sie die Ziele Ihrer Datenpipeline klar und deutlich, einschließlich der Datenquellen, Datenumwandlungen und Datenziele. Auf diese Weise können Sie den Entwurfs- und Implementierungsprozess steuern und sicherstellen, dass die Pipeline den spezifischen Anforderungen Ihres Unternehmens gerecht wird.

Wählen Sie geeignete Datenverarbeitungstools: Wählen Sie die richtigen Datenverarbeitungstools und -technologien, die für Ihren speziellen Anwendungsfall geeignet sind. Berücksichtigen Sie Faktoren wie Datenvolumen, Datenkomplexität und Anforderungen an die Echtzeit- bzw. Stapelverarbeitung. Zu den gängigen Datenverarbeitungstools gehören Apache Spark, Apache Flink, Apache Kafka, Apache Nifi und andere.

Verwenden Sie verteilte Verarbeitung: Nutzen Sie Techniken der verteilten Verarbeitung, um Ihre Datenpipeline horizontal zu skalieren und so die parallele Verarbeitung großer Datenmengen zu ermöglichen. Verteilte Verarbeitungsframeworks wie Apache Spark und Apache Flink sind für die Verarbeitung großer Datenmengen ausgelegt und bieten Skalierbarkeit und Fehlertoleranz.

Optimieren Sie die Datenspeicherung: Wählen Sie geeignete Datenspeichertechnologien, die effizient und skalierbar für Ihre Datenpipeline sind. Berücksichtigen Sie dabei Faktoren wie Datenvolumen, Datenstruktur und Abfrageleistung. Zu den gängigen Datenspeichertechnologien gehören relationale Datenbanken, NoSQL-Datenbanken, Data Lakes und Cloud-basierte Speicherdienste.

Implementieren Sie Datenpartitionierung und -umschichtung: Partitionieren Sie Daten und verteilen Sie sie über mehrere Verarbeitungsknoten, um die Verarbeitungsleistung zu optimieren. Das Shuffling von Daten über Knoten hinweg sollte auf ein Minimum reduziert werden, da dies zu einem Leistungs-Overhead führen kann. Ziehen Sie Techniken wie Datenpartitionierung, Bucketing und Bucketing-Spaltenformate in Betracht, um die Datenspeicherung und -verarbeitung zu optimieren.

Überwachen und optimieren Sie die Leistung: Überwachen Sie regelmäßig die Leistung Ihrer Datenpipeline und optimieren Sie sie im Hinblick auf ihre Effizienz. Verwenden Sie Überwachungstools und -techniken, um Leistungsengpässe, Datenschiefstände oder andere Probleme zu erkennen, und ergreifen Sie geeignete Maßnahmen zur Optimierung der Pipeline.

Sichern Sie die Datenqualität: Implementieren Sie Datenvalidierung und Datenqualitätsprüfungen in verschiedenen Phasen der Datenpipeline, um sicherzustellen, dass die Daten korrekt, vollständig und konsistent sind. Validieren Sie Daten anhand von vordefinierten Regeln, Geschäftslogik oder Referenzdaten, um Datenqualitätsprobleme zu identifizieren und zu beheben.

Implementieren Sie Fehlerbehandlung und Fehlertoleranz: Entwerfen Sie Ihre Datenpipeline so, dass Fehler und Ausfälle angemessen behandelt werden. Implementieren Sie Mechanismen zur Fehlerbehandlung wie Wiederholungsversuche, Protokollierung und Warnmeldungen, um Fehler zu erkennen und zu beheben. Erwägen Sie die Implementierung von Fehlertoleranztechniken wie Replikation, Backup und Disaster Recovery, um die Haltbarkeit und Verfügbarkeit der Daten zu gewährleisten.

Planen Sie für Skalierbarkeit und Wachstum: Entwerfen Sie Ihre Datenpipeline so, dass sie skalierbar ist und sich an veränderte Datenmengen und Verarbeitungsanforderungen anpassen lässt. Planen Sie zukünftiges Wachstum ein und berücksichtigen Sie Faktoren wie z. B.

Wie lassen sich Datenqualität und -integrität in Data-Engineering-Workflows sicherstellen?

Die Sicherstellung der Datenqualität und -integrität ist in Data-Engineering-Workflows von entscheidender Bedeutung, um zu gewährleisten, dass die verarbeiteten Daten korrekt, vollständig und konsistent sind. Im Folgenden finden Sie einige Best Practices zur Gewährleistung der Datenqualität und -integrität in Data-Engineering-Workflows:

Datenvalidierung: Implementieren Sie Datenvalidierungsprüfungen in verschiedenen Phasen des Data-Engineering-Workflows, um die Daten anhand vordefinierter Regeln, Geschäftslogik oder Referenzdaten zu validieren. Dies kann eine Datentypvalidierung, eine Bereichsvalidierung, eine Formatvalidierung und andere geschäftsspezifische Validierungsprüfungen umfassen, um sicherzustellen, dass die Daten den erwarteten Qualitätsstandards entsprechen.

Datenprofilierung: Führen Sie ein Datenprofiling durch, um die Merkmale der Daten zu verstehen, z. B. Datenverteilungen, Datenmuster und Datenanomalien. Die Erstellung von Datenprofilen hilft bei der Identifizierung potenzieller Datenqualitätsprobleme, z. B. fehlende Werte, doppelte Daten oder inkonsistente Daten, und ermöglicht entsprechende Abhilfemaßnahmen.

Datenbereinigung: Implementieren Sie Datenbereinigungstechniken, um Datenqualitätsprobleme zu bereinigen und zu korrigieren. Dies kann Techniken wie Datendeduplizierung, Datenstandardisierung und Datenanreicherung umfassen, um sicherzustellen, dass die Daten konsistent und genau sind.

Datentransformation und -anreicherung: Implementieren Sie Prozesse zur Datentransformation und -anreicherung, um sicherzustellen, dass die Daten so transformiert und angereichert werden, wie es für die nachgelagerte Verarbeitung erforderlich ist. Dies kann Datennormalisierung, Datenaggregation, Datenanreicherung mit externen Datenquellen und andere Datenverarbeitungstechniken zur Gewährleistung der Datenintegrität und -konsistenz umfassen.

Datenverfolgung und Dokumentation: Erstellen Sie eine Datenabfolge und -dokumentation, um den Ursprung, die Umwandlung und den Fluss der Daten während des gesamten Data-Engineering-Workflows zu verfolgen. Dies hilft dabei, den Datenfluss zu verstehen, potenzielle Datenqualitätsprobleme zu erkennen und die Datenintegrität in jeder Phase des Workflows sicherzustellen.

Überwachung der Datenqualität: Implementieren Sie Prozesse zur Überwachung der Datenqualität, um die Qualität der Daten im Data-Engineering-Workflow kontinuierlich zu überwachen. Dies kann automatische Datenqualitätsprüfungen, Datenprofilerstellung und Datenvalidierung anhand vordefinierter Qualitätsstandards umfassen. Die Überwachung der Datenqualität hilft bei der Identifizierung und Behebung von Datenqualitätsproblemen in Echtzeit und gewährleistet, dass die Daten genau und konsistent bleiben.

Datenverwaltung: Implementieren Sie Data-Governance-Praktiken, um Datenstandards, Richtlinien und Verfahren für Data-Engineering-Workflows festzulegen. Dazu gehören die Definition von Datenqualitätsregeln, Dateneigentum, Datendokumentation und Datenverknüpfung. Data Governance trägt dazu bei, dass die Daten gemäß den festgelegten Qualitätsstandards und Compliance-Anforderungen verarbeitet werden.

Fehlerbehandlung und -protokollierung: Implementieren Sie robuste Mechanismen zur Fehlerbehandlung und -protokollierung, um alle Datenqualitätsprobleme oder Verarbeitungsfehler zu erfassen und zu protokollieren, die während des Data Engineering Workflows auftreten. Dies hilft bei der rechtzeitigen Erkennung und Behebung von Datenqualitätsproblemen und gewährleistet die Integrität und Konsistenz der Daten.

Testen und Validieren: Durchführen

Was sind die Herausforderungen und Überlegungen beim Umgang mit Big Data in Data-Engineering-Projekten?

Quelle : educba.com

Der Umgang mit Big Data in Data-Engineering-Projekten kann aufgrund der schieren Menge, Geschwindigkeit und Vielfalt der Daten besondere Herausforderungen und Überlegungen mit sich bringen. Im Folgenden finden Sie einige Herausforderungen und Überlegungen, die Sie beachten sollten:

Skalierbarkeit: Big-Data-Projekte erfordern skalierbare Lösungen, die große Datenmengen effizient verarbeiten können. Dazu gehören der Entwurf von Datenpipelines, die horizontal skaliert werden können, die Nutzung von verteilten Computing-Frameworks wie Apache Spark, Apache Flink oder Apache Hadoop und die Verwendung von Cloud-basierten Lösungen, die sich automatisch an die Datenlast anpassen.

Leistung: Die Verarbeitung und Analyse großer Datenmengen kann zeitaufwändig sein, und die Leistung wird zu einem entscheidenden Faktor. Die Optimierung von Data-Engineering-Workflows im Hinblick auf die Leistung, wie z. B. die Reduzierung von Datenbewegungen, die Optimierung von Datenspeicherung und -abruf und die Verwendung paralleler Verarbeitungstechniken, ist für eine zeitnahe und effiziente Verarbeitung von Big Data unerlässlich.

Datenintegration: Big-Data-Projekte beinhalten häufig die Integration von Daten aus verschiedenen Quellen, einschließlich strukturierter und unstrukturierter Daten, Streaming- und Batch-Daten sowie Daten aus mehreren Systemen. Zu den Herausforderungen bei der Datenintegration gehören die Kompatibilität der Datenformate, die Datenaufnahme, die Datentransformation und die Datenkonsolidierung aus verschiedenen Quellen, was eine sorgfältige Prüfung und Planung erfordert.

Datenspeicherung und -verarbeitung: Big-Data-Projekte erfordern oft besondere Überlegungen zur Datenspeicherung und -verarbeitung. Dies kann die Verwendung von verteilten Dateisystemen wie Hadoop Distributed File System (HDFS), spaltenorientierten Datenbanken wie Apache Cassandra oder Cloud-basierten Speicherlösungen wie Amazon S3 oder Google Cloud Storage beinhalten. Die Wahl der richtigen Datenspeicherungs- und -verarbeitungstechnologien, die den Projektanforderungen entsprechen, ist von entscheidender Bedeutung.

Datenverwaltung: Die Verwaltung von Daten in Big-Data-Projekten kann aufgrund des Volumens und der Vielfalt der beteiligten Daten sehr komplex sein. Die Gewährleistung des Datenschutzes, der Datensicherheit und der Einhaltung von Vorschriften wie GDPR oder HIPAA ist eine Herausforderung. Die Implementierung von Data-Governance-Richtlinien, Datenmaskierungstechniken, Verschlüsselung und Zugriffskontrollen zum Schutz sensibler Daten ist bei Big-Data-Projekten von entscheidender Bedeutung.

Datenqualität: Die Aufrechterhaltung der Datenqualität in Big-Data-Projekten kann aufgrund der schieren Menge und Vielfalt der Daten eine Herausforderung darstellen. Die Sicherstellung der Datengenauigkeit, -vollständigkeit und -konsistenz wird im Umgang mit Big Data immer schwieriger. Die Implementierung robuster Datenvalidierungs-, Datenprofilierungs- und Datenbereinigungstechniken ist für die Gewährleistung der Datenqualität in Big-Data-Projekten unerlässlich.

Komplexität der Datenverarbeitung: Big-Data-Projekte beinhalten häufig komplexe Datenverarbeitungsaufgaben, wie z. B. Datenverarbeitung in Echtzeit, komplexe Datentransformationen und Algorithmen für maschinelles Lernen. Die Bewältigung der Komplexität von Datenverarbeitungsaufgaben, die Optimierung von Algorithmen für große Datensätze und die Handhabung komplexer Datenflüsse erfordern eine sorgfältige Überlegung und Planung.

Kostenüberlegungen: Big-Data-Projekte können mit erheblichen Infrastrukturkosten verbunden sein, einschließlich Speicher, Pro

Welches sind die gängigen Tools im Data Engineering?

Moderne Data-Engineering-Workflows stützen sich auf eine Vielzahl von Tools und Technologien zur effizienten Verarbeitung und Verwaltung großer Datenmengen. Hier sind einige der beliebtesten:

Apache Spark: Apache Spark ist ein weit verbreitetes, verteiltes Open-Source-Datenverarbeitungs-Framework für Big Data-Analysen. Es bietet eine einheitliche Datenverarbeitungs-Engine für Stapelverarbeitung, Stream-Verarbeitung, maschinelles Lernen und Graphenverarbeitung und ist damit ein vielseitiges Tool für moderne Data-Engineering-Workflows.

Apache Kafka: Apache Kafka ist eine verteilte Streaming-Plattform, die für den Aufbau von Echtzeit-Daten-Streaming-Pipelines verwendet wird. Es bietet eine verteilte und fehlertolerante Architektur für die Verarbeitung großer Mengen von Datenströmen in Echtzeit und ist daher ein beliebtes Tool für den Aufbau moderner Datenverarbeitungspipelines.

Apache Airflow: Apache Airflow ist eine Open-Source-Plattform für die Orchestrierung komplexer Daten-Workflows. Sie bietet ein skalierbares und erweiterbares Framework für den Entwurf, die Planung und die Überwachung von Datenpipelines und ist daher eine beliebte Lösung für die Verwaltung komplexer Datenverarbeitungsabläufe.

Apache Flink: Apache Flink ist ein Open-Source-Framework für die Stream-Verarbeitung, das leistungsstarke Event-Time-Verarbeitungsfunktionen für die Verarbeitung von Echtzeit-Datenströmen bietet. Es unterstützt Stapelverarbeitung, Stream-Verarbeitung, Ereigniszeitverarbeitung und Zustandsverwaltung und ist daher für moderne Data-Engineering-Workflows sehr beliebt.

AWS Glue: AWS Glue ist ein vollständig verwalteter Extraktions-, Transformations- und Ladedienst (ETL), der von Amazon Web Services (AWS) bereitgestellt wird. Er bietet einen serverlosen Ansatz für die Erstellung und Verwaltung von Datenpipelines in der Cloud und ist daher für cloudbasierte Data-Engineering-Workflows sehr beliebt.

Google Cloud Dataflow: Google Cloud Dataflow ist ein verwalteter Stream- und Batch-Verarbeitungsdienst, der von Google Cloud bereitgestellt wird. Er bietet ein einheitliches Programmiermodell für die Verarbeitung von Daten in Stapelverarbeitung und in Echtzeit und ist daher für den Aufbau von Datenverarbeitungspipelines in der Cloud sehr beliebt.

Apache NiFi: Apache NiFi ist ein Open-Source-Tool zur Verwaltung von Datenflüssen, das eine webbasierte Schnittstelle für die Entwicklung, Verwaltung und Überwachung von Datenflüssen bietet. Es bietet einen visuellen und intuitiven Ansatz für die Erstellung von Datenpipelines, was es zu einem beliebten Tool für Datenverarbeitungsabläufe macht.

Apache Cassandra: Apache Cassandra ist eine hochgradig skalierbare und verteilte NoSQL-Datenbank, die für die Verarbeitung großer Datenmengen auf mehreren Knoten und Clustern ausgelegt ist. Sie ist beliebt für Anwendungsfälle, die hohe Verfügbarkeit, Fehlertoleranz und Datenzugriff mit geringer Latenz erfordern, und eignet sich daher für moderne Data-Engineering-Workflows.

Apache Beam: Apache Beam ist ein einheitliches Open-Source-Programmiermodell für die Stapel- und Stream-Verarbeitung von Daten. Es bietet eine High-Level-API für die Erstellung von Datenverarbeitungspipelines, die auf verschiedenen Datenverarbeitungs-Engines wie Apache Spark, Apache Flink und Google Cloud Dataflow ausgeführt werden können, was es zu einem beliebten Tool für die Erstellung portabler Datenverarbeitungs-Workflows macht.

SQL-basierte Datenbanken: SQL-basierte Datenbanken, wie z. B. MySQL, PostgreSQL und Microsoft SQL Server, sind

Wie unterscheidet sich Data Engineering von Data Science und Data Analytics?

Quelle : edureka.co

Data Engineering, Data Science und Data Analytics sind drei unterschiedliche, aber miteinander verknüpfte Bereiche im Bereich der datengestützten Entscheidungsfindung. Hier sind die Hauptunterschiede zwischen ihnen:

Daten-Engineering: Data Engineering umfasst die Konzeption, Entwicklung und Verwaltung von Datenpipelines, Datenarchitekturen und Dateninfrastrukturen, um eine effiziente und zuverlässige Datenverarbeitung zu ermöglichen. Dateningenieure sind für den Aufbau skalierbarer und robuster Datenpipelines verantwortlich, die Daten sammeln, speichern, umwandeln und für die weitere Analyse bereitstellen. Data Engineering konzentriert sich auf die effiziente Handhabung, Speicherung und Verarbeitung von Daten, um deren Verfügbarkeit, Qualität und Integrität für nachgeschaltete Datenkonsumenten sicherzustellen.

Datenwissenschaft: Die Datenwissenschaft umfasst die Anwendung statistischer, mathematischer und maschineller Lerntechniken, um Daten zu analysieren und Erkenntnisse, Muster und Trends abzuleiten. Datenwissenschaftler verwenden Tools und Techniken, um Daten zu untersuchen und zu modellieren, Prognosemodelle zu erstellen und Erkenntnisse zu gewinnen, die die Entscheidungsfindung unterstützen. Data Science konzentriert sich darauf, Wissen und Erkenntnisse aus Daten zu extrahieren, um Geschäftsziele zu unterstützen, Muster und Trends zu erkennen und datengesteuerte Entscheidungen zu treffen.

Datenanalyse: Die Datenanalyse umfasst den Prozess der Untersuchung, Bereinigung, Umwandlung und Visualisierung von Daten, um Erkenntnisse und Trends aufzudecken. Datenanalysten verwenden verschiedene Techniken und Tools, um Daten zu untersuchen, zu analysieren und zu interpretieren, um die Entscheidungsfindung zu unterstützen. Die Datenanalyse konzentriert sich auf das Verständnis von Datenmustern, Trends und Beziehungen, um Chancen zu erkennen, Prozesse zu optimieren und Geschäftseinblicke zu gewinnen.

Zusammenfassend lässt sich sagen, dass sich Data Engineering auf den Entwurf und die Entwicklung von Datenpipelines und -infrastrukturen konzentriert, dass Data Science die Anwendung statistischer und maschineller Lerntechniken zur Datenanalyse beinhaltet und dass Data Analytics den Prozess der Untersuchung und Visualisierung von Daten beinhaltet, um Erkenntnisse zu gewinnen. Obwohl diese Bereiche miteinander verbunden sind und oft zusammenarbeiten, haben sie unterschiedliche Rollen, Verantwortlichkeiten und Fähigkeiten. Dateningenieure liefern die Grundlage für Datenwissenschaftler und Datenanalysten, um Daten effektiv zu analysieren und Erkenntnisse daraus abzuleiten. Datenwissenschaftler und Datenanalysten nutzen die von Dateningenieuren bereitgestellten Daten, um Datenanalysen durchzuführen und Geschäftsentscheidungen zu treffen.

Was sind die besten Praktiken für die Datenmodellierung und das Datenbankdesign im Data Engineering?

Datenmodellierung und Datenbankdesign sind wichtige Aspekte der Datentechnik, da sie die Grundlage für die effiziente und genaue Speicherung, Organisation und Abfrage von Daten bilden. Im Folgenden finden Sie einige Best Practices für die Datenmodellierung und das Datenbankdesign im Data Engineering:

Verstehen Sie die Datenanforderungen: Beginnen Sie mit einem gründlichen Verständnis der Datenanforderungen des Projekts. Arbeiten Sie mit Datenverantwortlichen, z. B. Geschäftsanalysten und Datenwissenschaftlern, zusammen, um Anforderungen zu sammeln, Dateneinheiten, Attribute, Beziehungen und Erwartungen an die Datenqualität zu definieren. Dadurch wird sichergestellt, dass das Datenmodell und der Datenbankentwurf mit den geschäftlichen Anforderungen und Zielen übereinstimmen.

Wählen Sie das richtige Datenmodell: Wählen Sie das geeignete Datenmodell, das am besten zu den Datenanforderungen und dem Anwendungsfall passt. Zu den gängigen Datenmodellen, die im Data Engineering verwendet werden, gehören relationale, dimensionale, hierarchische und NoSQL-Modelle. Jedes Modell hat seine Stärken und Schwächen, und die Auswahl des richtigen Modells ist entscheidend für eine effiziente Datenspeicherung und -abfrage.

Normalisieren und Denormalisieren von Daten: Bei der relationalen Datenmodellierung ist die Normalisierung eine Technik zur Beseitigung von Redundanzen und Inkonsistenzen in Daten. Die Denormalisierung kann jedoch strategisch eingesetzt werden, um die Leistung in bestimmten Szenarien zu verbessern, z. B. bei leseintensiven Workloads. Wählen Sie ein ausgewogenes Verhältnis zwischen Normalisierung und Denormalisierung auf der Grundlage der Datenzugriffsmuster und Leistungsanforderungen.

Planen Sie für Skalierbarkeit und Leistung: Berücksichtigen Sie die Skalierbarkeits- und Leistungsaspekte des Datenmodells und des Datenbankdesigns. Optimieren Sie Datenstrukturen wie Indizes, Partitionen und Clustering-Schlüssel, um eine effiziente Datenabfrage und -speicherung zu gewährleisten. Planen Sie bei Bedarf eine horizontale Skalierbarkeit, um zukünftiges Datenwachstum zu bewältigen.

Sicherstellung der Datenintegrität und -konsistenz: Implementieren Sie Datenintegritäts- und Konsistenzprüfungen, wie z. B. Primär- und Fremdschlüssel-Beschränkungen, eindeutige Beschränkungen und Datenvalidierungsregeln, um die Genauigkeit und Konsistenz der Daten zu gewährleisten. Durchsetzung von Datenvalidierungs- und Bereinigungsregeln bei der Datenaufnahme, um zu verhindern, dass ungültige oder inkonsistente Daten in die Datenbank gelangen.

Planen Sie für die Datensicherheit: Integrieren Sie bewährte Verfahren für die Datensicherheit in das Datenbankdesign, z. B. Authentifizierung, Autorisierung, Verschlüsselung und Auditing, um sensible Daten vor unbefugtem Zugriff zu schützen und den Datenschutz sowie die Einhaltung von Datenvorschriften zu gewährleisten.

Berücksichtigen Sie Datenpartitionierung und Sharding: Planen Sie Datenpartitionierungs- und Sharding-Strategien ein, um die Daten auf mehrere Knoten oder Cluster zu verteilen und so die Leistung und Skalierbarkeit zu verbessern. Partitionieren Sie Daten auf der Grundlage logischer oder physischer Attribute, wie z. B. Zeit, Geografie oder Kunde, um den Datenabruf und die Speicherung zu optimieren.

Planen Sie Datensicherung und -wiederherstellung: Implementieren Sie robuste Datensicherungs- und Wiederherstellungsmechanismen zum Schutz vor Datenverlusten aufgrund von Hardwareausfällen, Softwarefehlern oder anderen unvorhergesehenen Ereignissen. Führen Sie regelmäßig Datensicherungen durch und testen Sie Datenwiederherstellungsprozesse, um die Haltbarkeit und Verfügbarkeit der Daten zu gewährleisten.

Dokumentieren und Pflegen von D

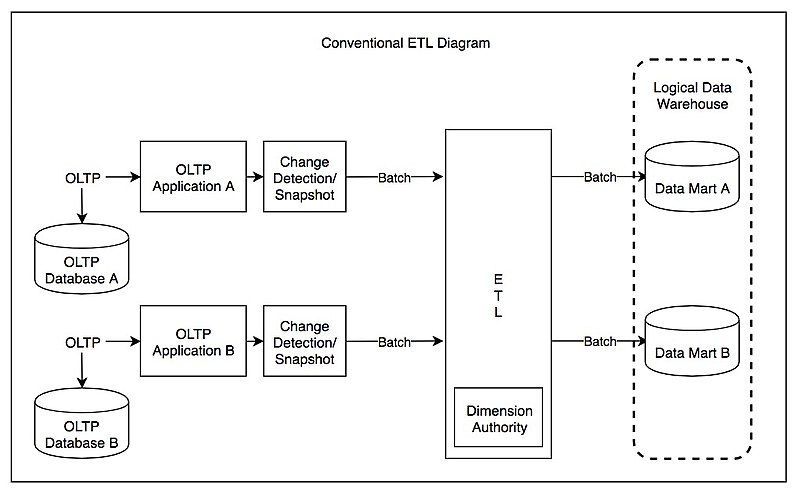

Wie gehen Sie mit Datenintegrations- und Datentransformationsaufgaben in einer Data-Engineering-Pipeline um?

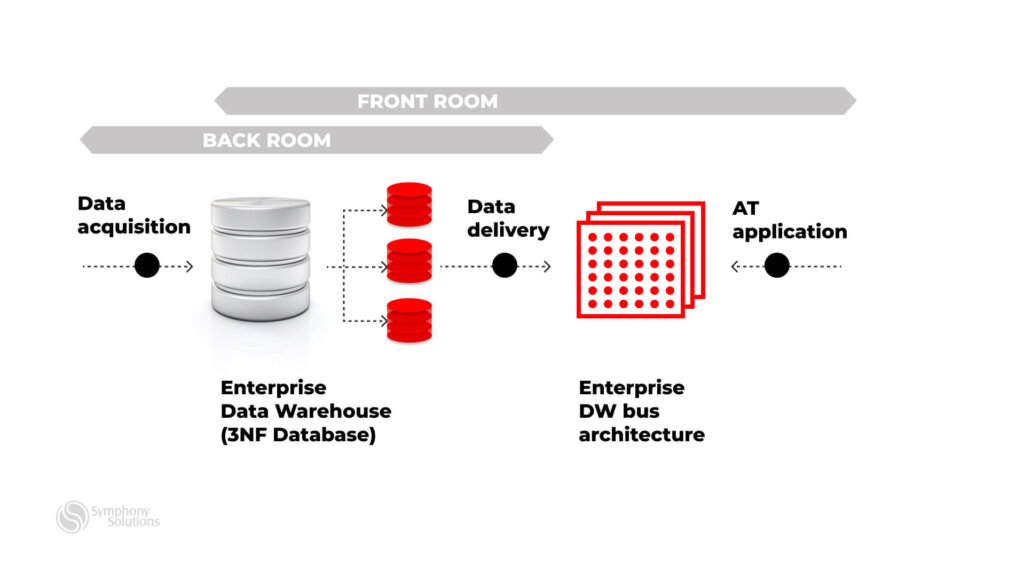

Quelle : en.wikipedia.org

Datenintegration und Datentransformation sind entscheidende Schritte in einer Data-Engineering-Pipeline, da sie das Extrahieren, Bereinigen und Transformieren von Daten aus verschiedenen Quellen in ein für die Speicherung, Analyse und Nutzung geeignetes Format beinhalten. Im Folgenden werden einige gängige Ansätze und Best Practices für die Handhabung von Datenintegrations- und Datentransformationsaufgaben in einer Data-Engineering-Pipeline vorgestellt:

Extrahieren, Transformieren, Laden (ETL): ETL ist ein gängiger Ansatz für die Datenintegration und -transformation. Bei diesem Ansatz werden Daten aus verschiedenen Quellen extrahiert, in ein gemeinsames Format oder eine gemeinsame Struktur umgewandelt und in ein Zielsystem geladen, z. B. ein Data Warehouse, einen Data Lake oder eine Datenbank. ETL-Tools und -Frameworks wie Apache NiFi, Apache Airflow oder kommerzielle Lösungen wie Informatica PowerCenter oder Microsoft SQL Server Integration Services (SSIS) werden üblicherweise zur Automatisierung des ETL-Prozesses eingesetzt.

Datenumwandlung: Data Wrangling ist ein Prozess, bei dem Daten bereinigt, strukturiert und umgewandelt werden, um sie für die Analyse geeignet zu machen. Zu den Aufgaben des Data Wrangling gehören in der Regel Datenbereinigung, Datenvalidierung, Datenanreicherung, Datenaggregation, Datenanreicherung und Datenanreicherung. Data Wrangling kann mit speziellen Data Wrangling-Tools wie Trifacta oder OpenRefine oder mit Datenvisualisierungstools mit Datenaufbereitungsfunktionen wie Tableau oder Power BI durchgeführt werden.

Daten-Streaming: Daten-Streaming ist ein alternativer Ansatz für die Datenintegration und -umwandlung, bei dem die Daten in Echtzeit oder nahezu in Echtzeit verarbeitet werden, sobald sie in das System eingespeist werden. Daten-Streaming-Frameworks wie Apache Kafka, Apache Flink oder Apache Spark Streaming ermöglichen die Verarbeitung von Daten in Echtzeit und ermöglichen Datenverarbeitung und -analyse mit geringer Latenz.

Daten-Orchestrierung: Die Datenorchestrierung umfasst die Koordinierung und Verwaltung von Datenintegrations- und -umwandlungsaufgaben über verschiedene Systeme und Prozesse hinweg. Datenorchestrierungstools wie Apache Airflow bieten Funktionen zum Definieren, Planen und Überwachen von Datenworkflows, einschließlich Datenextraktions-, -umwandlungs- und -ladeaufgaben. Dies ermöglicht eine effiziente Verwaltung und Koordination komplexer Data-Engineering-Pipelines.

Datenqualität und -validierung: Die Sicherstellung der Datenqualität und -validierung ist ein wichtiger Aspekt der Datenintegration und -transformation. Implementieren Sie Datenvalidierungsprüfungen, wie z. B. Datentypvalidierung, Bereichsvalidierung, Eindeutigkeitsvalidierung und Konsistenzvalidierung, um sicherzustellen, dass die Daten korrekt, vollständig und konsistent sind. Datenqualitätstools wie DataWrangler, Great Expectations oder Apache Nifi können zur Automatisierung von Datenvalidierung und Datenqualitätsprüfungen eingesetzt werden.

Regeln für die Datenzuordnung und -umwandlung: Definieren Sie klare Regeln für die Datenzuordnung und -umwandlung, um eine konsistente Datenumwandlung über verschiedene Quellen und Formate hinweg sicherzustellen. Die Datenzuordnung definiert die Beziehungen zwischen Datenelementen in verschiedenen Datenquellen, und die Datenumwandlungsregeln legen fest, wie die Daten vom Quell- in das Zielformat umgewandelt werden sollen. Dokumentieren und pflegen Sie die Datenzuordnung

Was sind die häufigsten Fehler, die bei Data-Engineering-Projekten zu vermeiden sind, um eine erfolgreiche Datenverarbeitung und -analyse zu gewährleisten?

Data-Engineering-Projekte können komplex und herausfordernd sein, und es ist wichtig, sich der häufigsten Fallstricke und Fehler bewusst zu sein, die für eine erfolgreiche Datenverarbeitung und -analyse zu vermeiden sind. Hier sind einige häufige Fallstricke und Fehler, die bei Data-Engineering-Projekten zu vermeiden sind:

Schlechte Datenqualität: Schlechte Datenqualität kann zu ungenauen, inkonsistenten und unzuverlässigen Ergebnissen führen. Die Validierung und Bereinigung von Daten in jeder Phase der Data-Engineering-Pipeline, einschließlich Dateneingabe, Datenumwandlung und Datenspeicherung, ist von entscheidender Bedeutung. Implementieren Sie Datenvalidierungsprüfungen, Datenbereinigungstechniken und Datenanreicherungsprozesse, um die Datenqualität sicherzustellen.

Fehlende Data Governance: Data Governance bezieht sich auf die Verwaltung und Überwachung von Datenbeständen, einschließlich Datenintegrität, Datensicherheit, Datenschutz und Datenkonformität. Bei Data-Engineering-Projekten müssen unbedingt angemessene Data-Governance-Praktiken eingeführt werden, um sicherzustellen, dass die Daten effektiv und konform verwaltet werden. Entwickeln Sie Data-Governance-Richtlinien, implementieren Sie Datensicherheitsmaßnahmen und halten Sie die Datenschutzbestimmungen ein, um datenbezogene Probleme zu vermeiden.

Unzureichende Skalierbarkeit und Leistung: Bei Data-Engineering-Projekten werden oft große Datenmengen verarbeitet, und Skalierbarkeit und Leistung sind entscheidende Faktoren, die berücksichtigt werden müssen. Unzureichende Skalierbarkeit und Leistung können zu langsamen Verarbeitungszeiten, erhöhter Ressourcenauslastung und ineffizienter Datenverarbeitung führen. Optimieren Sie die Datenverarbeitungsalgorithmen, nutzen Sie die Parallelverarbeitung und planen Sie eine horizontale Skalierung, um eine effiziente Datenverarbeitung zu gewährleisten.

Fehlende Dokumentation und Metadatenverwaltung: Eine ordnungsgemäße Dokumentation und Metadatenverwaltung sind für das Verständnis und die Pflege von Data-Engineering-Pipelines unerlässlich. Werden Datenquellen, Datenumwandlungsregeln, Datenzuordnung und andere relevante Informationen nicht dokumentiert, kann dies zu Verwirrung, Fehlern und Schwierigkeiten bei der Fehlerbehebung und Wartung von Data-Engineering-Workflows führen. Dokumentieren Sie Data-Engineering-Prozesse gründlich, pflegen Sie Metadaten und legen Sie angemessene Dokumentationsverfahren fest.

Unzureichende Fehlerbehandlung und -überwachung: Bei Data-Engineering-Prozessen können Fehler auftreten, z. B. Fehler bei der Dateneingabe, bei der Datenumwandlung oder bei der Datenspeicherung. Es ist von entscheidender Bedeutung, robuste Mechanismen zur Fehlerbehandlung zu implementieren, wie z. B. Protokollierung, Warnmeldungen und Ausnahmebehandlung, um Fehler rechtzeitig zu erfassen und zu beheben. Die Überwachung von Data-Engineering-Pipelines und die proaktive Behebung von Problemen kann datenbezogene Probleme verhindern und eine reibungslose Datenverarbeitung gewährleisten.

Mangelnde Zusammenarbeit und Kommunikation: Bei Data-Engineering-Projekten arbeiten oft verschiedene Teams zusammen, z. B. Dateningenieure, Datenwissenschaftler und Unternehmensvertreter. Ein Mangel an effektiver Zusammenarbeit und Kommunikation kann zu Missverständnissen, Fehlinterpretationen und falsch abgestimmten Erwartungen führen, was wiederum zu datenbezogenen Problemen führt. Fördern Sie die Zusammenarbeit zwischen verschiedenen Teams, richten Sie klare Kommunikationskanäle ein und stimmen Sie die Erwartungen ab, um den Erfolg sicherzustellen.